Google introduces, a differentially private LLM built for secure data handling

2025/09/16 HelpNetSecurity — Google が発表した、大規模言語モデル (LLM) VaultGemma は、トレーニング中に用いる機密データを、非公開に保つよう設計されたものだ。このモデルは、差分プライバシー技術を用いて個々のデータ・ポイントの露出を防ぐため、医療/金融/政府などの分野での、機密情報の安全な取り扱いを可能にする。

VaultGemma は Google の Gemma ファミリーモデルの一部であり、プライバシー保護型 AI システムを、試験的に利用する研究者や開発者を対象として展開される。Google は、このプライバシー重視のモデルをオープンソース化することで、検証/導入における容易なアプローチを提供し、安全な機械学習の研究を加速させる考えである。

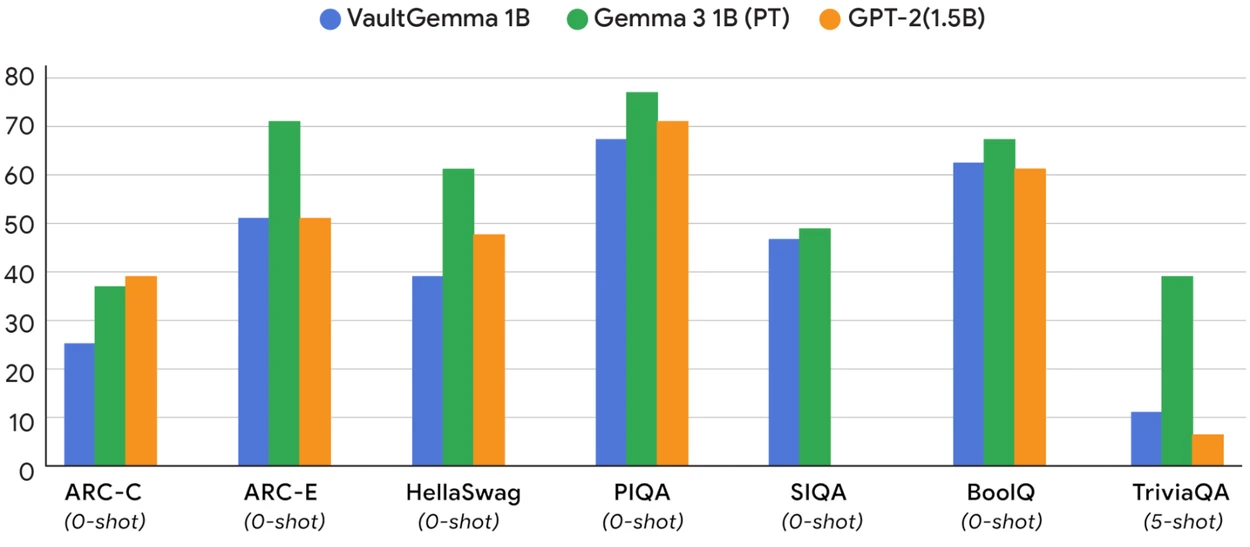

上記のグラフで、VaultGemma 1B (差分プライバシー) と、非プライバシー版 (Gemma3 1B) や従来のベースライン (GPT-2 1.5B) との比較が可能だ。約 5 年前の非プライバシー・モデルに匹敵する有用性が、DP トレーニングから得られることが示されている。その一方で、プライバシーに必要なリソースへの投資が定量化されるという。

最初からプライバシーに重点を置いた設計

VaultGemma は、差分プライバシーを用いて学習する。具体的に言うと、このモデルによる個人情報の学習の範囲を制限するための、数学的な手法が用いられる。Google によると、このモデルでは、学習過程で公開されるデータ量の制御により、機密性の高いデータセットであっても、安全に利用できるという。

Google の開発チームは、オープン・データ・セットと合成データを用いて VaultGemma を構築した。その目的は、学習データの詳細を記憶しないモデルを作成することであり、出力におけるデータ漏洩のリスクを軽減することである。

今回の発表の中で Google が強調しているのは、VaultGemma が差分プライバシーの厳格な定義を満たし、外部の審査機関による検証をパスしていることだ。つまり、プライバシー保護を謳いながら、正式な基準を満たさないモデルとは、異なるレベルにあると主張している。

モデルの構築方法

VaultGemma では 10 億パラメータ版が用意されており、大規模の商用モデルよりも、小型のモデルでのテストが容易であるという。Google が、このサイズを採用した理由は、研究者が標準的なクラウド環境やローカル・マシンでの、実行を可能にするためである。

このモデルは、トレーニング・データに対して、統計ノイズを追加する方式で訓練されている。このノイズは、個々のレコードの再構成/識別を不可能にすることで、安全性を高める効果を持つが、調整が不適切であれば学習が困難となり、パフォーマンス低下を招く可能性がある。

この課題に対処するために、Google は特殊な最適化手法を開発し、プライバシー保証とモデル精度のバランスを維持している。開発チームによると、差分プライバシーで学習されていない同規模モデルと比較して、VaultGemma はベンチマーク・タスクで優れた性能を示しているという。

開発者と研究者のためのツール

このモデルを公開した Google は、それに加えて、差分プライバシー・モデルのトレーニングと評価を支援する、コードおよびドキュメントも提供している。このパッケージには、評価スクリプトやプライバシー・アカウンティング・ツールが含まれるため、差分プライバシー基準に対する合否も確認できる。

今回の発表により Google が目指すのは、プライバシー重視の AI システムを構築してテストするための、信頼できる出発点をコミュニティに提供することである。モデルの重みからプライバシー・ツールに至るまでのフルスタックを提供することで、ゼロからの環境構築を必要とせずに、研究者たちは実験を開始できる。

プライバシー優先モデルが AI セキュリティを変える可能性

このようなプライバシー保護モデルには、サイバー・セキュリティおよびコンプライアンス領域において、重要な役割を果たす可能性がある。多くの組織は法的/倫理的な理由から、AI 学習に利用できない機密データを保有しているが、強力なプライバシー保証を備えたモデルであれば、それらのデータを安全に利用できるようになるだろう。VaultGemma 自体は、本番導入を前提としていないが、こうした可能性を探るテストベッドとして機能する。

Google は、VaultGemma と関連ツールの開発を継続していくという。設計の段階から、安全な AI システムを構築するための、大規模な取り組みの一環として VaultGemma を位置づけている。

Google が発表した、VaultGemma という LLM を紹介する記事です。AI と機密情報という観点で見ると、従来の AI モデルでは、そのまま学習データが記憶されてしまうため、出力に漏れるというリスクがありました。VaultGemma は、差分プライバシーを取り入れることで、データの一部を再構成されないようにする仕組みを持っています。この方式では、ノイズが加えられるため、設定が不適切だと精度低下を招く可能性もありますが、それに対応する仕組みが設計/開発されているようです。よろしければ、カテゴリ AI/ML も、ご参照ください。

You must be logged in to post a comment.