LocalGPT – A Secure Local Device Focused AI Assistant Built in Rust

2026/02/08 CyberSecurityNews — AI アシスタントである ChatGPT や Claude が、クラウド基盤を席巻する時代になった。それにより、ユーザー・データがリモート侵害にさらされるが、LocalGPT と呼ばれる新しい Rust ベースのツールが堅牢な代替案を提示している。約 27MB の単一バイナリとして開発された LocalGPT は、完全にローカル・デバイス上で動作し、機密のメモリとタスクをクラウド以外に保持する。

OpenClaw フレームワークに着想を得ており、互換性も備える LocalGPT は、永続メモリ/自律動作/最小限の依存関係を重視しており、エンタープライズ・ユーザーとプライバシー重視ユーザーにとってサイバー・セキュリティ上の注目点となっている。

LocalGPT の中核には Rust のメモリ・セーフ・モデルがあり、C/C++ 製 AI ツールで頻発するバッファ・オーバーフローなどの脆弱性を排除している。Node.js/Docker/Python を使用しないため、攻撃対象領域は極めて小さく、パッケージ・マネージャの悪用やコンテナ脱出の余地もない。

プロジェクトの GitHub README は、「あなたのデータは、あなたの手元にあり続ける」と宣言している。すべての処理はユーザーのマシン内で閉じて行われ、SaaS 型 AI に内在する中間者攻撃やデータ流出リスクを抑止するローカル・ファースト設計となっている。

LocalGPT のセキュリティ機能

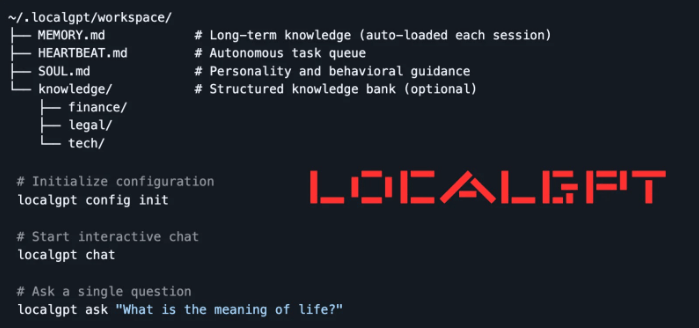

LocalGPT の永続メモリは、”~/.localgpt/workspace/” 配下のプレーンな Markdown ファイルを用いて管理される。それらの構成要素は、長期間にわたる知識用の MEMORY.md/タスクキュー用の HEARTBEAT.md/人格ガイドライン用の SOUL.md/構造化データ用の knowledge などである。

これらの情報に対しては、SQLite FTS5 による高速な全文検索が可能となり、fastembed ローカル埋め込みを用いた sqlite-vec による、セマンティック検索も実現されている。外部データベースやクラウドとの同期は使用されず、永続化に伴うリスクが低減されている。

また、自律的なハートビート機能により、ユーザーは指定したアクティブ時間帯 (例: 09:00–22:00) にバックグラウンド・タスクを委任できる。デフォルト間隔は 30 分であり、定常作業を無監督でオフロードするが、ローカル実行に限定されているため、マルウェアによる横展開は防止される。

マルチ・プロバイダー対応として、Anthropic (Claude)/OpenAI/Ollama が含まれ、”~/.localgpt/config.toml” に API キーを設定することでハイブリッド構成が可能になる。ただし、主要な処理はデバイス内に留まる。

インストールは、cargo install localgpt のみで完了する。初期設定は localgpt config init/対話セッションは localgpt chat/単発の問い合わせは localgpt ask “What is the meaning of life?” という形で実行される。

デーモンモード (localgpt daemon start) ではバックグラウンド・サービスが起動し、”/api/chat” や “/api/memory/search?q=<query>” といった HTTP API エンドポイントを介した連携が可能となる。

CLI コマンドは、デーモン管理 (start/stop/status)、メモリ操作 (search/reindex/stats)、設定表示などを網羅している。Web UI および eframe ベースのデスクトップ GUI も提供され、利用しやすいフロントエンドが用意されている。Tokio による非同期処理/Axum による API サーバ/SQLite 拡張を用いることで、低リソース環境向けに最適化されている。

LocalGPT は OpenClaw 互換性を備え、SOUL/MEMORY/HEARTBEAT ファイルおよび “skill” をサポートする。これにより、ベンダー・ロックインのない、モジュール化されたエクステンションが監査可能な形で実現される。

セキュリティ研究者たちが評価するのは、SQLite ベースのインデックスが改竄耐性に優れている点と、エアギャップ環境でのフォレンジックや機密運用に適している点である。レッドチームのシナリオでは、その最小構成がリバース・エンジニアリングを困難にする。

MITRE によると、AI フィッシングやプロンプト・インジェクション攻撃は、2025 年に 300% 増加しているが、それに対抗する LocalGPT は、強化されたベースラインを提供する。金融と法務の分野における初期導入企業は、”knowledge/” の分離構造による情報の混入や漏洩の防止を高く評価している。

LLM のハルシネーションや、ローカル環境特有の攻撃リスクは皆無でないが、LocalGPT は AI 制御をビッグテックから取り戻す選択肢を提示している。このツールは GitHub からダウンロード可能であり、ワークフローの防御強化に寄与する。

AI アシスタントのローカル実行ツール LocalGPT について解説する記事です。LocalGPT の背景にあるのは、従来のクラウド型 AI (SaaS) が抱える、データに関する外部通信と、攻撃対象領域の広さです。それにより、AI エージェントを介したプロンプト・インジェクションが多発しています。また、クラウド型では、通信経路での中間者攻撃や、サーバ側でのデータ流出リスクが避けられませんが、LocalGPT は Rust 言語のメモリ・セーフ機能を活用し、バッファ・オーバーフローなどを根本から排除する設計をとっています。さらに、Python や Docker に依存しない単一バイナリ構成により、複雑な依存関係を悪用するサプライチェーン攻撃の隙を与えない点も特徴です。よろしければ、AI Agent での検索結果と、Prompt Injection での検索結果も、ご参照ください。

You must be logged in to post a comment.