AI Safety Summit: OWASP Urges Governments to Agree on AI Security Standards

2023/11/02 InfoSecurity — OWASP (Open Worldwide Application Security Project) によると、AI の急速な普及がもたらす危険を軽減するためには、AI を搭載するツールがもたらすセキュリティと倫理的リスクに関する、トップレベルの議論だけでは、もはや不十分だという。2023年11月1日~2日にイギリスのブレッチリー・パークで開催された AI Safety Summit に先立ち、この非営利団体はサミット参加者に対して、実用的な AI セキュリティ標準に合意し採用することを、迅速に推進すべきという行動喚起を促している。

OWASP は公開書簡の中で、「リスクを先取りする緊急の必要性と、AI に関するグローバルな業界セキュリティ標準の役割について、英国の NCSC (National Cyber Security Centre) の CEO である Lindy Cameron に心から賛同する」と述べている。ただし、それを実現するには、標準がバベルの塔にならないための調整が必要となる。

OWASP Top 10 for LLM の中心的なコントリビューターである John Sotiropoulos は、「私たちは、政策立案者や大規模な組織とトップレベルの議論を行い、リスクを探る必要性を認識している。その一方で、すでに行動を起こす時がきていると考えている。私たちが、先のことを計画している間にも、すでに AI は利用され、悪用されている。したがって、即座に対応する必要がある。たとえば、AI アプリケーションで見つかった脆弱性を、どのように報告すれば良いのか? 新しいフレームワークを作る必要があるのか?それとも、既存のフレームワークを更新するだけで良いのか?一時に全てを行うことはできないが、順次であっても全ては行えない。バランスを取ることが必要だと考える」と述べている。

OWASP が推進する AI セキュリティ標準とは?

公開書簡の中で OWASP は各国政府に対し、OWASP/Linux 財団のようなオープンスタンダード組織に目を向け、実用的な AI セキュリティ標準を採用するよう求めている。

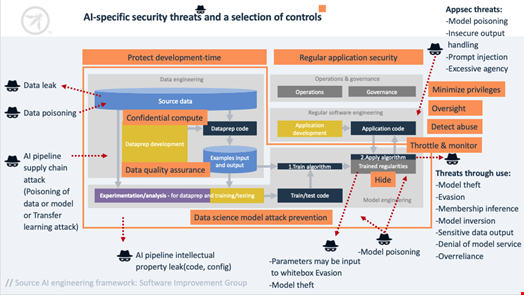

John Sotiropoulos は、「最初に思い浮かぶのは、OWASP Top 10 for LLM Applications だ。しかし、MITRE や NIST のような組織とも交渉している。もちろん、彼らも同じ意見である。さらに、OWASP と MITRE は、ATLAS フレームワークで協力しており、AI の脅威を含めた上で、進化する脅威の状況をマッピングすることを目的としている」と述べている。

さらに OWASP AI Exchange イニシアチブは、ISO/IEC 27090/OWASP Top 10 ML/CEN/CENELEC 規格 (EU AI Act のベース) を、AI の安全政策について各国政府が調整を行う上で、信頼できる必須の規格として挙げている。

公開書簡の中で、OWASP はサミットの参加者に対して要請したのは、AI セキュリティ標準の調整に取り組むためのコラボレーション・ハブとしての設立を目指す、非営利団体 AI Exchange への参加である。

AI Safety Summit に参加する各国政府は、現時点では OWASP Foundation の呼びかけに応じていないが、サイバー・セキュリティ機関の関係者を含むコミュニティの人々からは、大きなフィードバックを受けたと John Sotiropoulos は述べている。

また、10月30日に発表された、バイデン米大統領の “Executive Order on Safe, Secure AI” を称賛する John Sotiropoulos は、あらゆる AI システムが一般に公開される前に安全性を確保するための、広範なレッドチーム・テストに関する新たな基準を策定するよう、NIST に要請すると述べている。

AI 関係者が今すぐ実行できる6つのステップ

11月2日に Kainos の John Sotiropoulos および Suzanne Brink と、Lakera の CEOである David Haber ブログ記事を公表し、政府/政策立案者/AI ツール・プロバイダーが取るべき、いくつかの実行可能なステップを提示した。

以下は、その一例である:

- テストと保証の強化: 基本モデル・プロバイダーは、プロプライエタリ/オープンソース・モデルを一般に公開する前に、レッド・チーミングによる包括的なテストなどの、積極的な対策を採用する必要がある。

- OWASP Top 10 LLM のような、実用的なオープン・スタンダードを採用する。

- 矛盾した分類法/矛盾した脆弱性報告/一貫性のない防御リスクから、AI 開発の最前線にいる人々を守り、また、混乱させないために、標準の調整を加速させる。

- LLM アプリケーションを迅速にテストし、セキュアにするための、API 駆動型の自動化ソリューションなどの、自動化された防御に投資する。

- AI のセキュリティと安全性を評価する際に、データ倫理のフレームワークを用いて、セキュリティと倫理を統合する。

- Secure-by-Design と Ethics-by-Design による AI の提供を推進する。

つい先ほど、「MITRE ATT&CK v14 がリリース:フレームワークの拡張によりフィッシングなどに対抗」という記事をアップしましたが、その MITRE に負けないぐらいの勢いで、OWASP も悪意の手口の解析と文書化に取り組んでいますね。そして、ついに AI にまで、手を広げてきました。頑張って欲しいです。よろしければ、OWASP で検索も、ご利用ください。

You must be logged in to post a comment.