Microsoft leaks 38TB of private data via unsecured Azure storage

2023/09/18 BleepingComputer — 2020年7月以降において Microsoft の AI 研究部門は、GitHub パブリック・リポジトリに、オープンソースの AI 学習モデルをコントリビュートする際に、誤って 38TB の機密データを流出させていた。それから約3年後に、クラウド・セキュリティ企業である Wiz が発見したのは、流出した情報を含む Azure Blob ストレージ・バケットの、ミスコンフィグレーションされた URL が、Microsoft の従業員により不用意に共有されていたことだった。

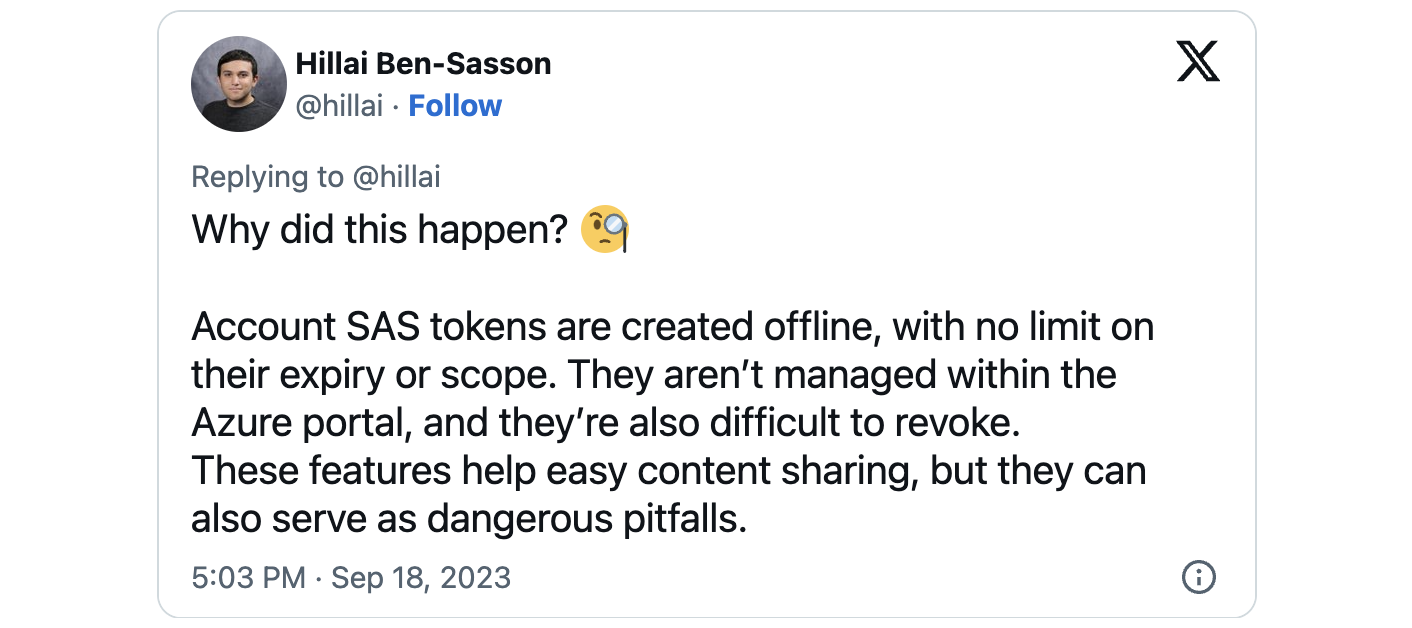

このデータの流出の原因が、共有ファイルの完全な制御を可能にする、過度に寛容な SAS (Shared Access Signature) トークンの使用によるものだと、Microsoft は突き止めた。この Azure の機能により、監視と失効が困難な方法でデータ共有が可能になると、Wiz の研究者たちは説明している。

SAS トークンは、正しく使用される場合において、ストレージ・アカウント内のリソースへの委任アクセスを許可するための、安全な手段を提供する。そのために必要になるのは、クライアントによるデータ・アクセスの正確な制御/クライアントが操作できるリソースの指定/リソースに関する権限の定義/SAS トークンの有効期間の決定などである。

Wiz は、「監視とガバナンスの欠如により、SAS トークンはセキュリティ・リスクをもたらす。Azure ポータル内でトークンを集中管理する方法を、Microsoft は提供していないため、これらのトークンを追跡するのは非常に困難だ。さらに、これらのトークンは、有効期限に上限がなく、事実上永久に存続するように設定することが可能だ。したがって、アカウント SAS トークンを外部共有に使用することは、安全性の面で不適切であり、避けるべきだ」と述べている。

Wiz の調査チームは、オープンソース・モデル以外にも、内部ストレージ・アカウントにより、38TB 相当の追加プライベート・データへのアクセスが誤って許可されていることも発見した。

それらの公開されたデータに含まれていたのは、Microsoft サービスのパスワード/秘密鍵に加えて、Microsoft 社員 359人 から発信された、3万件を超える Microsoft Teams 内部メッセージのアーカイブや、社員の個人情報のバックアップなどである。

9月18日 (月) に Microsoft Security Response Center (MSRC) が発表したアドバイザリには、「顧客データの流出はなく、このインシデントにより、他の内部サービスが危険にさらされることもなかった」と記されている。

2023年6月22日の時点で、このインシデントは Wiz から MSRC に報告され、6月24日に MSRC は SAS トークンを失効させることで、Azure ストレージ・アカウントへの全ての外部アクセスをブロックし、この問題を緩和した。

Wiz の CTO ある Ami Luttwak は、「AI はハイテク企業にとっての、大きな可能性を秘めている。しかし、データ・サイエンティストやエンジニアがたちが、新しい AI ソリューションの提供で競争する中、彼らが扱う大量のデータに対して必要とされるのは、さらなるセキュリ・ティチェックと安全策である。この新しいテクノロジーは、学習のための大量のデータを必要とする。多くの開発チームが大量のデータを操作/共有し、また、パブリックな OSS プロジェクトでの共同作業も必要になるため、今回の Microsoft のようなケースの監視/回避は、ますます難しくなっている」と BleepingComputer に語っている。

Microsoft 自身が間違ってしまうほど、いまのクラウドの正確なコンフィグレーションは難しいということなのでしょう。また、文中の「共有ファイルの完全な制御を可能にする、過度に寛容な SAS (Shared Access Signature) トークンの使用によるものだ」と言う部分も気になります。Azure のストレージに関しては、2023/09/16 にも「BlackCat ランサムウェア:Sphynx 暗号化ツールで Azure Storage を攻撃」という記事がありました。よろしければ、ご参照ください。

You must be logged in to post a comment.